Analizar el Archivo Robots.txt utilizando Parsero

Parsero es un script gratuito escrito en Python el cual lee el archivo Robots.txt de un servidor web y busca la entradas Deshabilitadas. Las entradas Deshabilitadas le indican a los motores de búsqueda los directorios o archivos hospedados sobre un servidor web los cuales no deben ser indexados. Por ejemplo “Disallow:/portal/login” implica el contenido de www. Dominio .com/portal /login no está permitido de ser indexado por los “crawlers” como Google, Bing, Yahoo, entre otros. De esta manera el administrador pueden decidir no compartir información sensible o privada con los motores de búsqueda.

Pero algunas veces estas rutas tipeadas en las entradas Deshabilitadas son directamente accedibles por los usuarios sin utilizar un motor de búsqueda, sólo visitando la URL y la Ruta, y algunas veces no están disponibles para ser visitadas por nadie. Es realmente común los administradores escriban muchas Deshabilitaciones, estando algunas de ellas disponibles y algunas de ellas no. Se puede utilizar Parsero para verificar el código de estado HTTP de cada entrada Deshabilitada para verificar automáticamente si estos directorios están disponibles o no.

También, el hecho de los administradores escriban un archivo Robots.txt, no significa los archivos o directorios tipeados en las entradas Deshabilitadas no sean indexados por Bing, Google, Yahoo, entre otros. Por esta razón, Parsero es capaz de buscar en Bing para localizar contenido indexado sin la autorización del administrador web. Parsero verificará el código de estado HTTP de la misma manera para cada resultado de Bing.

Para la siguiente demostración se instalará Parsero en Samurai WTF.

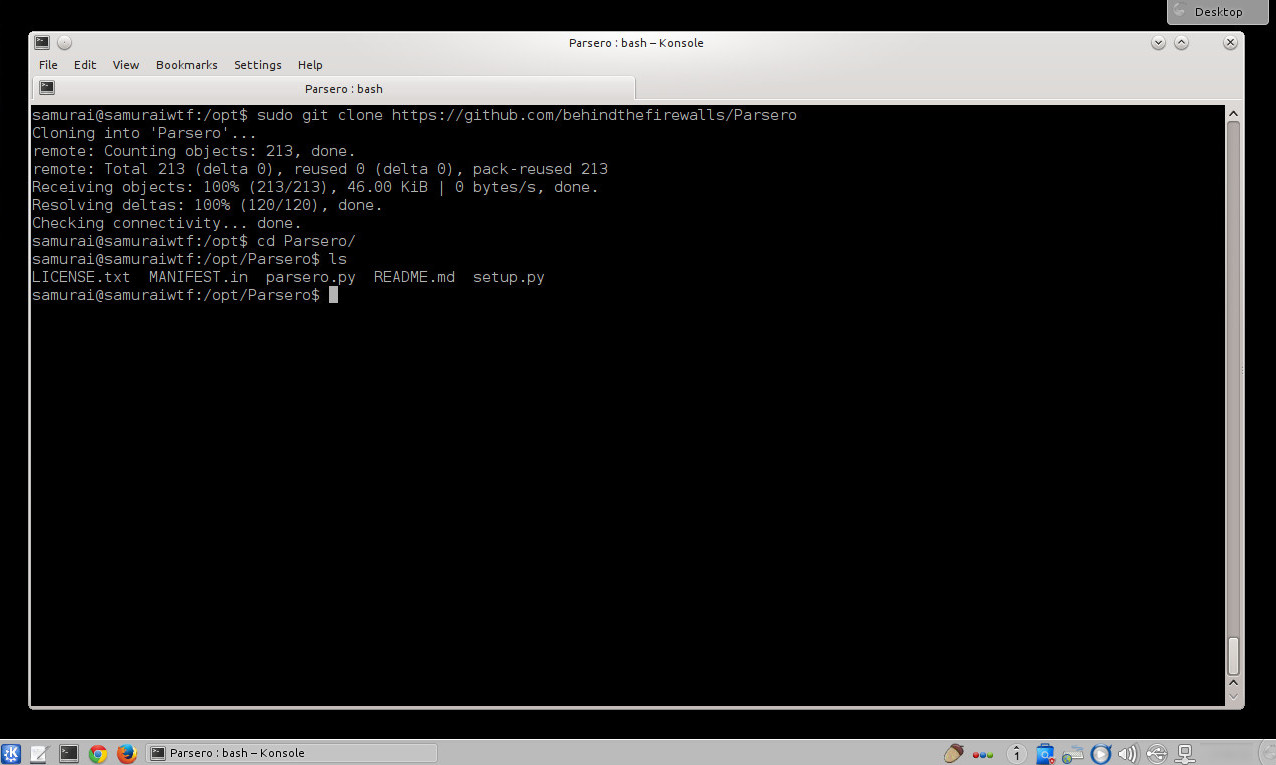

Descargar la versión más reciente de Parsero desde su repositorio github.

$ sudo git clone https://github.com/behindthefirewalls/Parsero

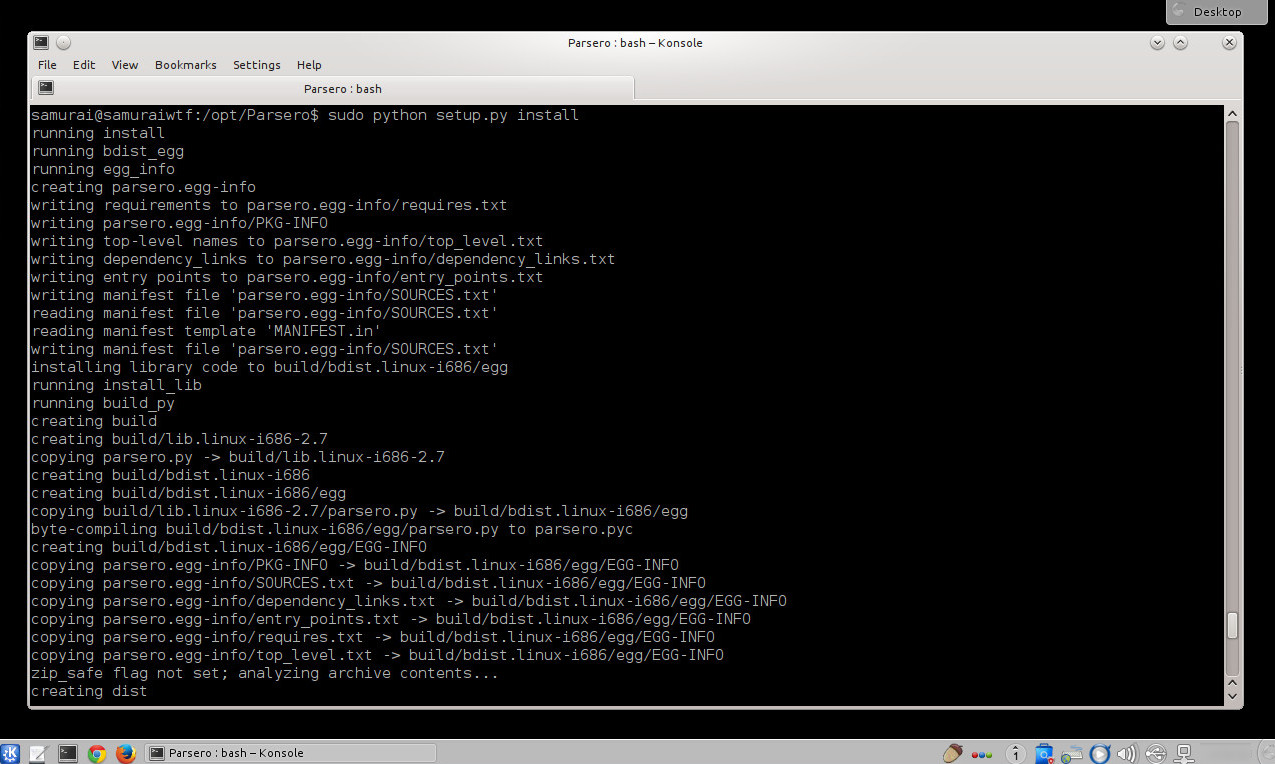

Ejecuta el script de nombre “setup.py” para proceder con su instalación.

$ sudo python setup.py install

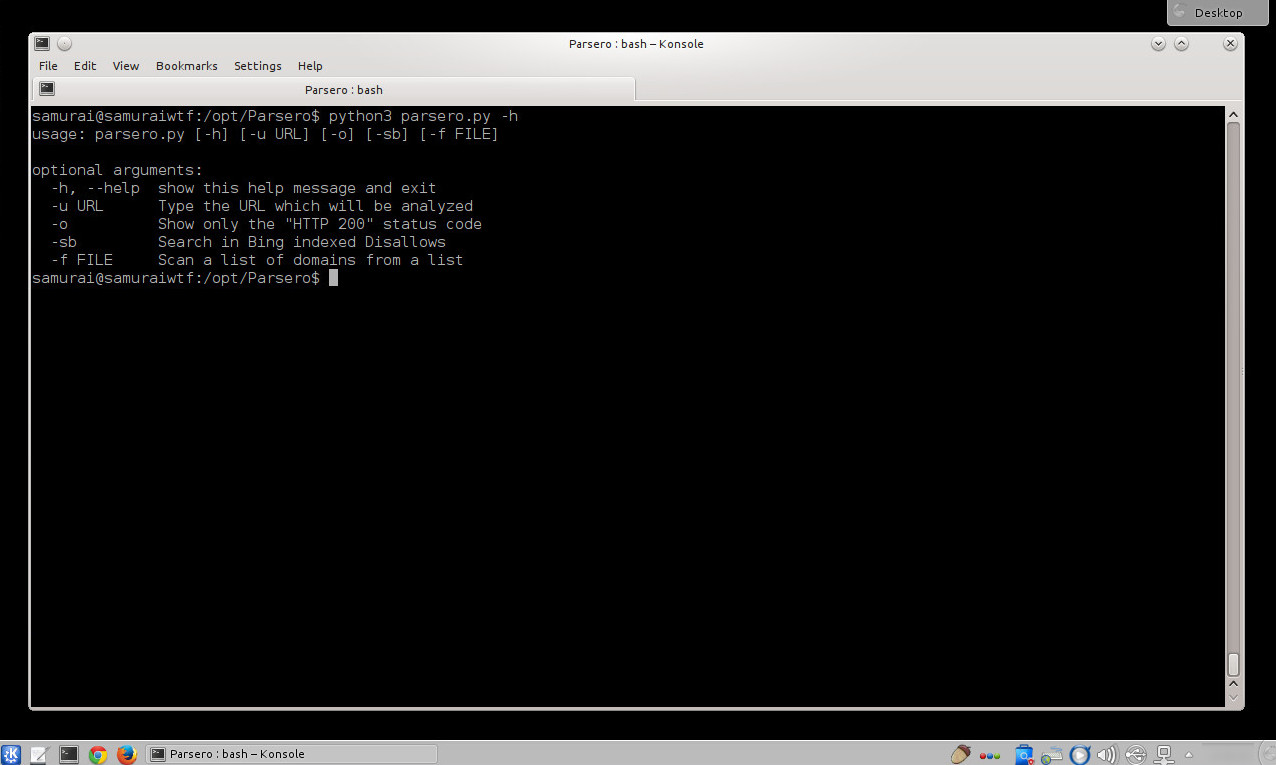

Ejecutar Parsero. La opción “-h” mostrará la ayuda de la herramienta.

$ python3 parsero.py -h

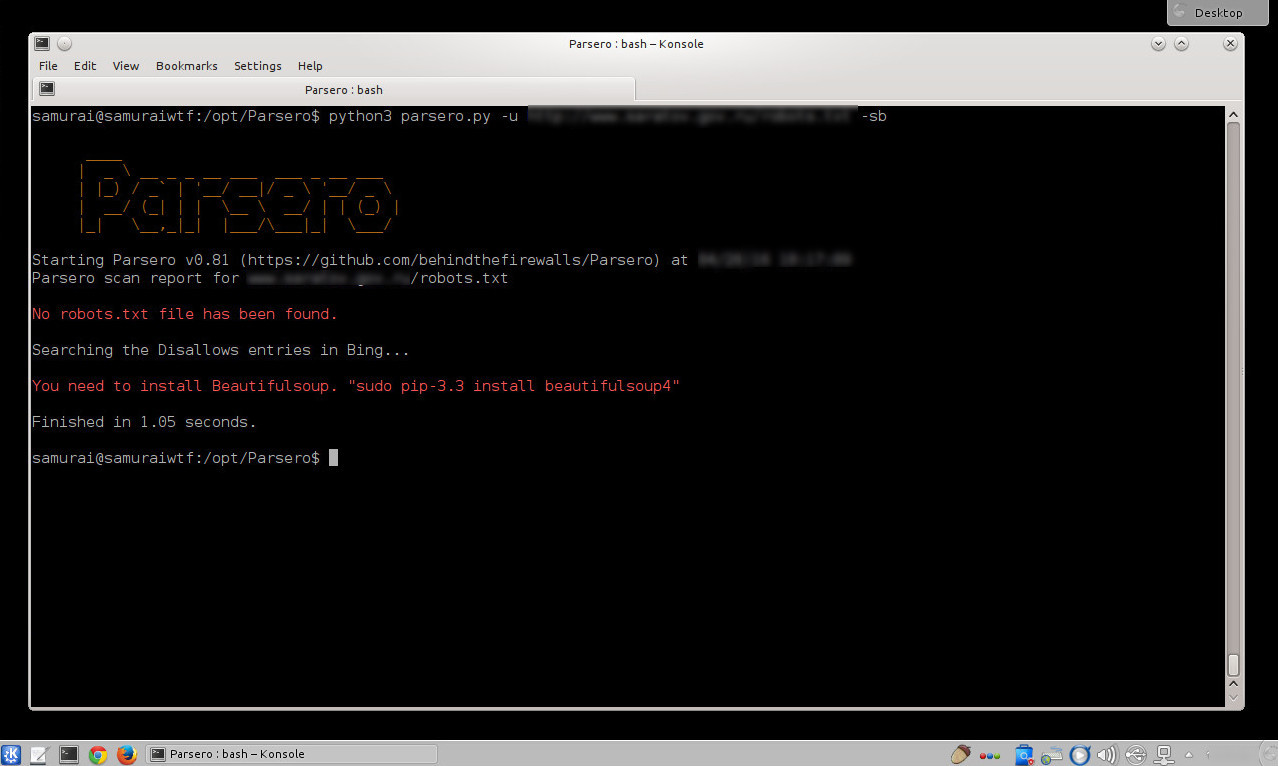

Al ejecutar la herramienta, se muestra un mensaje donde se indica la necesidad de instalar Beautifulsoup.

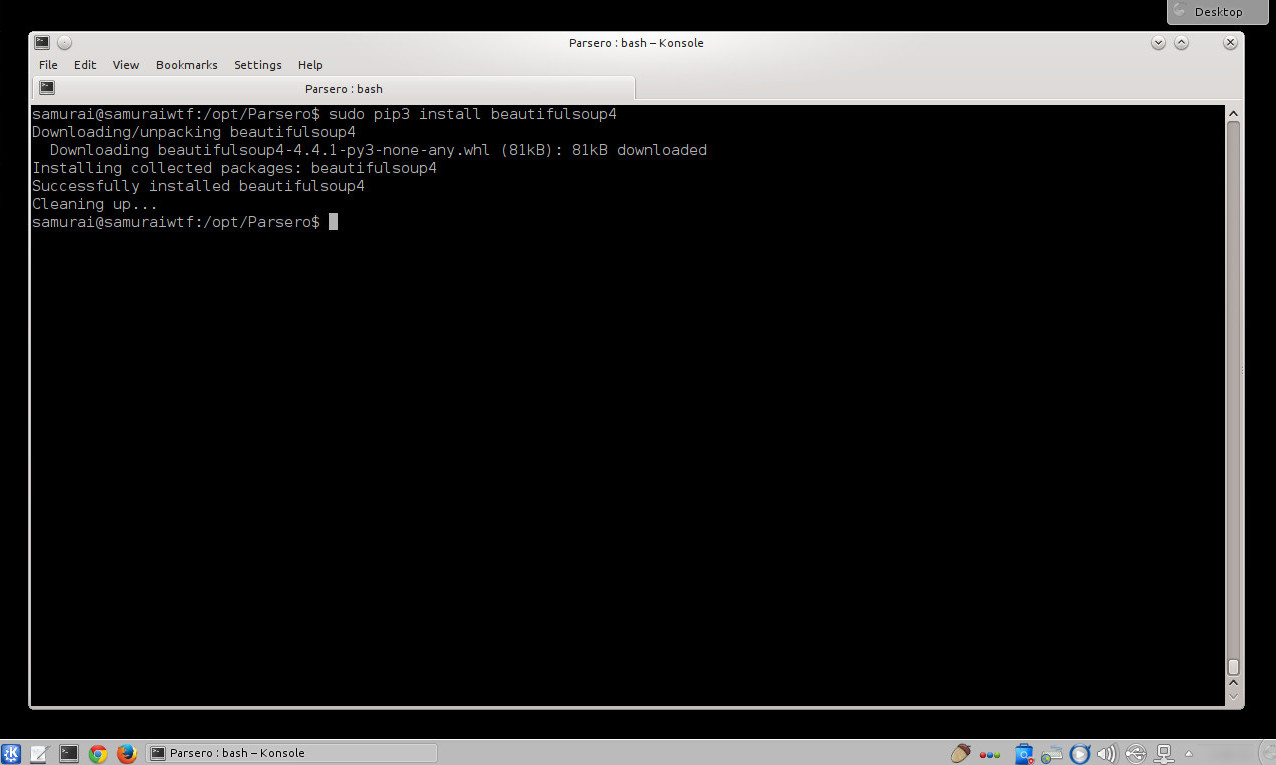

Se indica a pip3 instalar beautifulsoup4.

$ sudo pip3 install beautifulsoup4

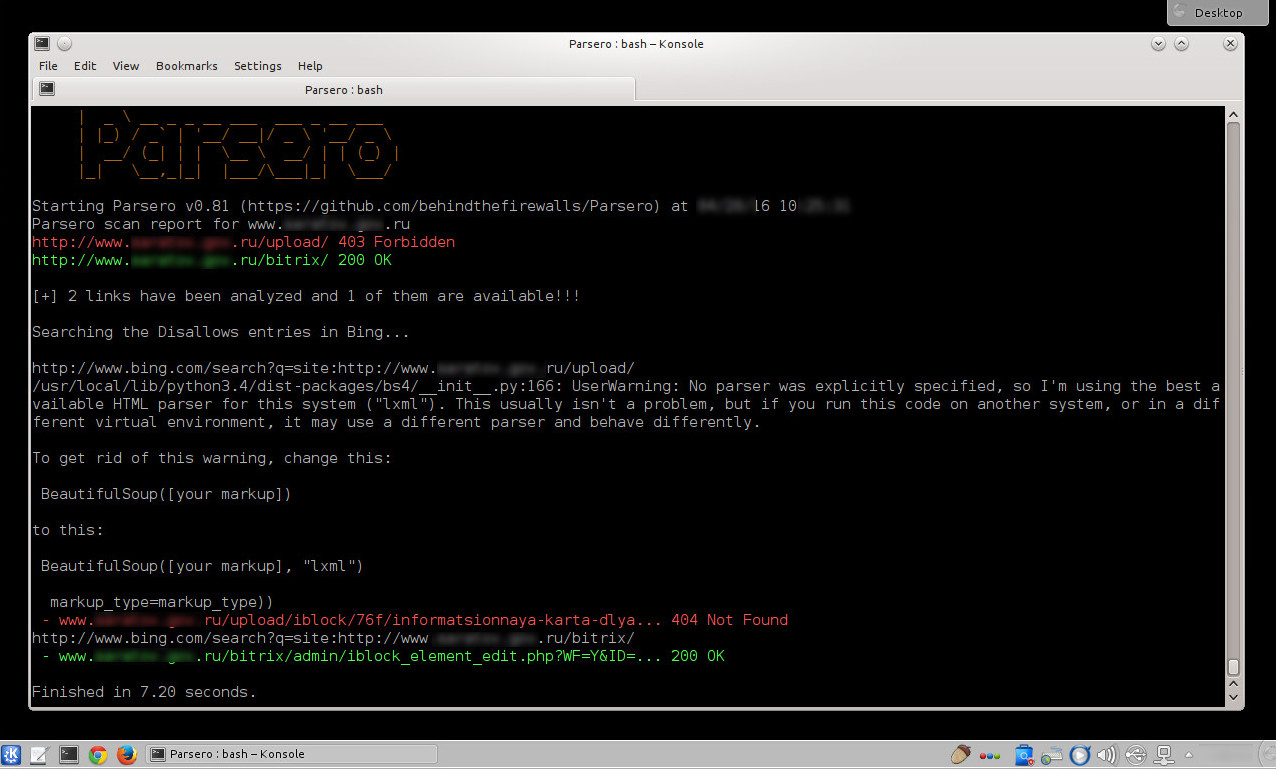

Ejecutar Parsero nuevamente. La opción -u define la URL a analizar. La opción “-sb” busca en Bing las Deshabilitaciones indexadas.

$ python3 parsero.py -u www. Dominio. info -sb

Los resultados obtenidos identifican un directorio con acceso prohibido. Y un segundo directorio el cual está disponible. Al buscar en Bing el enlace, no ha sido factible encontrarlo, y un segundo enlace es factible de ser accedido.

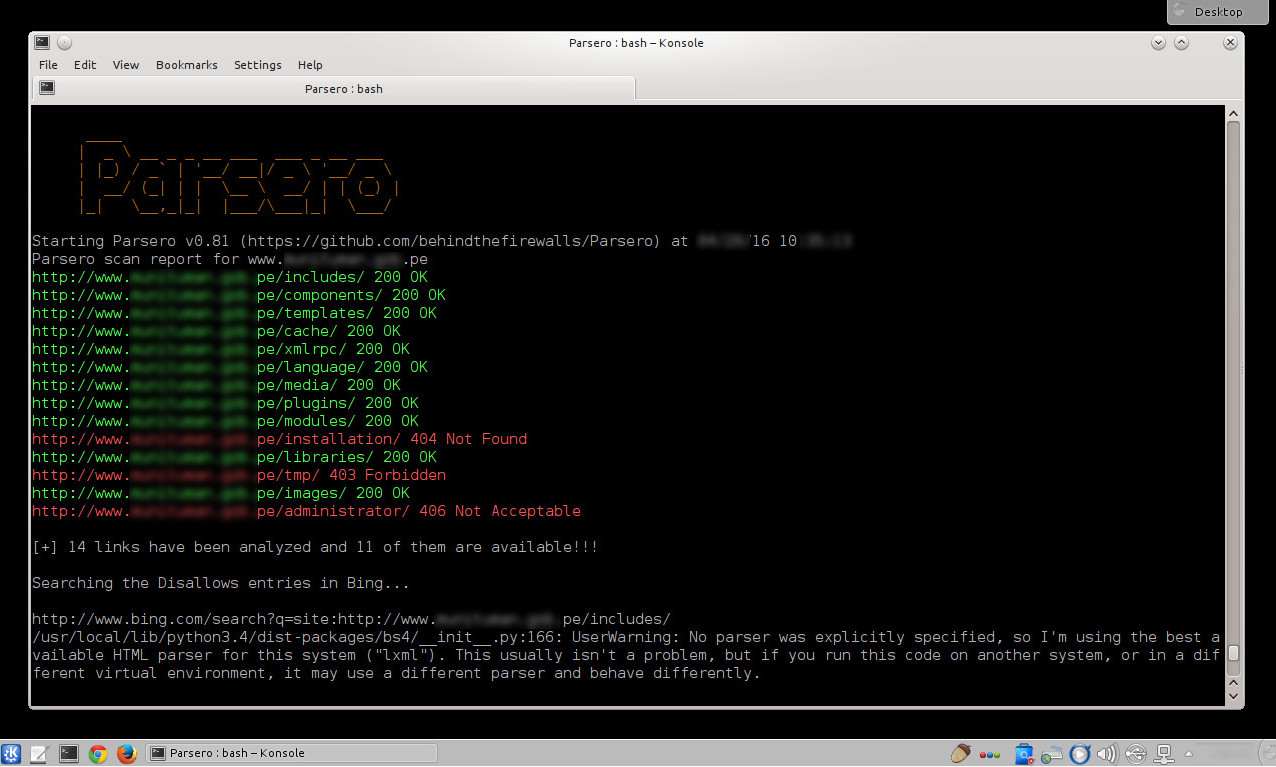

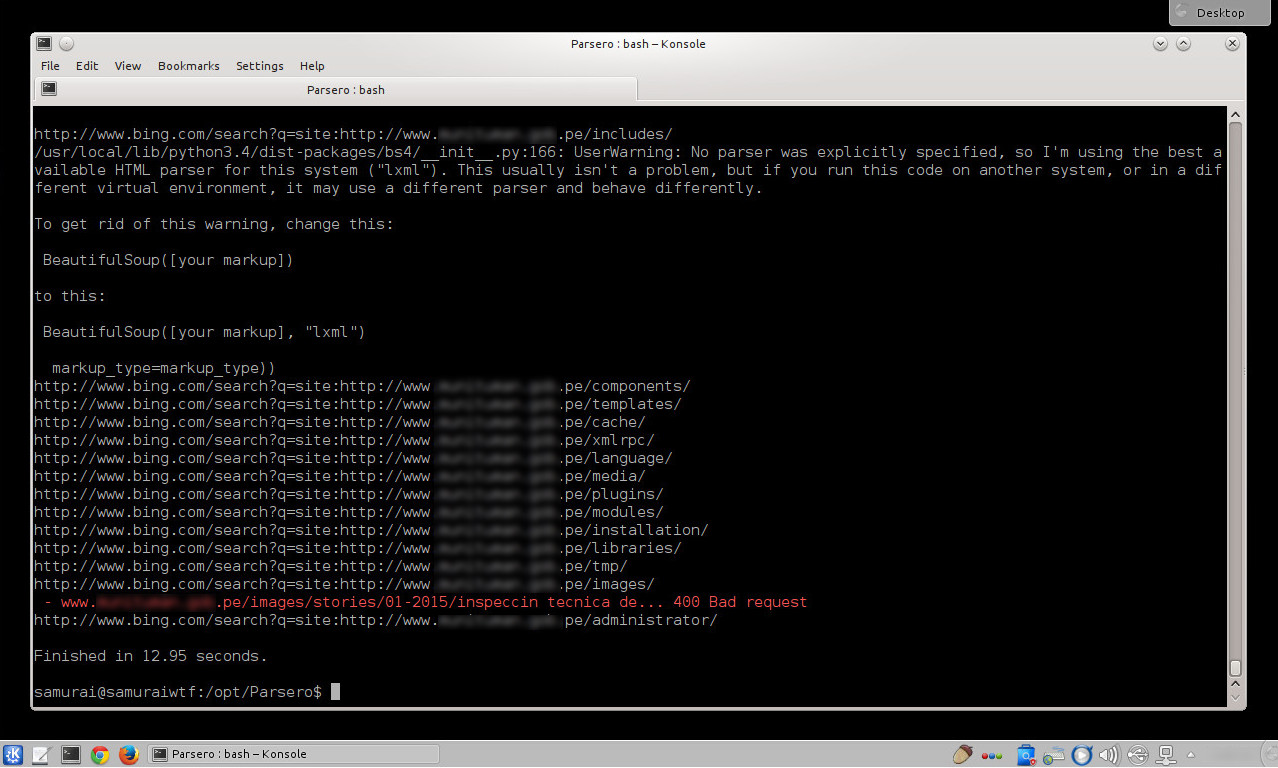

En los resultados obtenidos de la siguiente prueba se ha encontrado catorce enlaces, de los cuales once están disponibles. Uno no encontrado, uno prohibido y otro no aceptable.

$ python3 parsero.py -u www. Dominio2 . info -sb

En las búsquedas realizadas en Bing por estos directorios, únicamente uno de ellos devuelve el mensaje de ser una petición errónea.

La herramienta también permite mostrar únicamente los códigos de estado “HTTP 200” y escanear una lista de dominios desde un archivo.

Fuentes:

https://github.com/behindthefirewalls/Parsero

http://www.behindthefirewalls.com/2013/12/parsero-tool-to-audit-robotstx...

https://sourceforge.net/projects/samurai/

Sobre el Autor

Alonso Eduardo Caballero Quezada - ReYDeS

Instructor y Consultor Independiente en Ciberseguridad

Correo Electrónico: ReYDeS@gmail.com

Twitter: https://twitter.com/Alonso_ReYDeS

LinkedIn: https://pe.linkedin.com/in/alonsocaballeroquezada/

Facebook: https://www.facebook.com/alonsoreydes

Youtube: https://www.youtube.com/c/AlonsoCaballero