Unidad de datos es el término genérico utilizado en The Sleuth Kit para referirse hacia una agrupación de sectores consecutivos. Los sectores suelen tener 512 bytes y los sistemas de archivos los agrupan para formar unidades de almacenamiento más grandes. Por ejemplo pueden agrupar 8 sectores consecutivos de 512 bytes, para formar unidades de 4096 bytes cada uno. El sistema de archivos asigna una dirección hacia cada una de estas unidades de datos. Típicamente los sistema de archivos no proporcionan una dirección para cada sector. Sólo asigna y referencia a las unidades de datos.

Los siguientes son los términos utilizados por cada uno de los sistemas de archivos para referirse hacia una unidad de datos.

ExtX: fragmento

Fragmento es el término utilizado en los sistemas de archivos ExtX y UFS, para referirse hacia una agrupación de sectores consecutivos. Los sectores son típicamente de 512 bytes cada uno, y es más eficiente para un sistema de archivos asignar y utilizar múltiples sectores a la vez. Cada sistema de archivos utiliza un término diferente para el grupo resultante. The Sleuth Kit utiliza el término unidad de datos para referirse a la agrupación.

Estos sistemas de archivos también agruparán fragmentos consecutivos en bloques, pero las direcciones de los bloques son iguales a las direcciones de los fragmentos.

Tener en consideración, aunque los sistemas de archivos ExtX admiten fragmentos y bloques, típicamente tienen tamaños iguales (lo cual significa un bloque es igual a un fragmento).

FAT: sector (anotar FAT agrupa los sectores en clústeres, pero no todos los sectores son asignados hacia un clúster y, por lo tanto, las direcciones de los clústeres no cubren todo el sistema de archivos. The Sleuth Kit utiliza direcciones de sectores con FAT, así todas las partes del sistema de archivos pueden ser referenciadas.

Un sector es la más pequeña la unidad direccionable sobre un disco duro u otro medio de almacenamiento no volátil. Sobre un disco duro típico, un sector tiene un tamaño de 512 bytes. Los CD-ROM utilizan sectores de 4096 bytes, existiendo discos duros más nuevos saliendo con sectores de 4096 bytes.

A cada sector se le asigna una dirección iniciando en 0. Esto se denomina dirección LBA. Existen otros esquemas para direccionamiento utilizando geometría de la unidad, pero rara vez se utilizan.

Para eficiencia los sistemas de archivos suelen agrupar sectores consecutivos en unidades de datos (los nombres comunes incluyen clúster o bloque). Las unidades de datos también reciben direcciones.

FFS: fragmento (anotar FFS también agrupa múltiples fragmentos en bloques, pero cada fragmento tiene una dirección)

Fragmento es el término utilizado en los sistemas de archivos ExtX y UFS, para referirse hacia una agrupación de sectores consecutivos. Los sectores son típicamente de 512 bytes cada uno, y es más eficiente para un sistema de archivos asignar y utilizar múltiples sectores a la vez. Cada sistema de archivos utiliza un término diferente para el grupo resultante. The Sleuth Kit utiliza el término unidad de datos para referirse a la agrupación.

Estos sistemas de archivos también agruparán fragmentos consecutivos en bloques, pero las direcciones de los bloques son iguales a las direcciones de los fragmentos.

Tener en consideración, aunque los sistemas de archivos ExtX admiten fragmentos y bloques, típicamente tienen tamaños iguales (lo cual significa un bloque es igual a un fragmento).

HFS: bloque

El término bloque se utiliza en un par de contextos diferentes con The Sleuth Kit.

Unidad de datos

Bloque es el término utilizado en los sistemas de archivos HFS para referirse hacia una agrupación de sectores consecutivos. Los sectores suelen tener 512 bytes cada uno, y es más eficiente para un sistema de archivos asignar y utilizar varios sectores al mismo tiempo. Cada sistema de archivos utiliza un término diferente para el grupo resultante. The Sleuth Kit utiliza el término unidad de datos para referirse a la agrupación.

Bloque es también utilizado en los sistemas de archivos ExtX y UFS para referirse a una agrupación de fragmentos. Estos sistemas de archivos agrupan sectores en fragmentos y fragmentos en bloques. Sin embargo los bloques no reciben direcciones únicas. Su dirección es la dirección del primer fragmento del bloque.

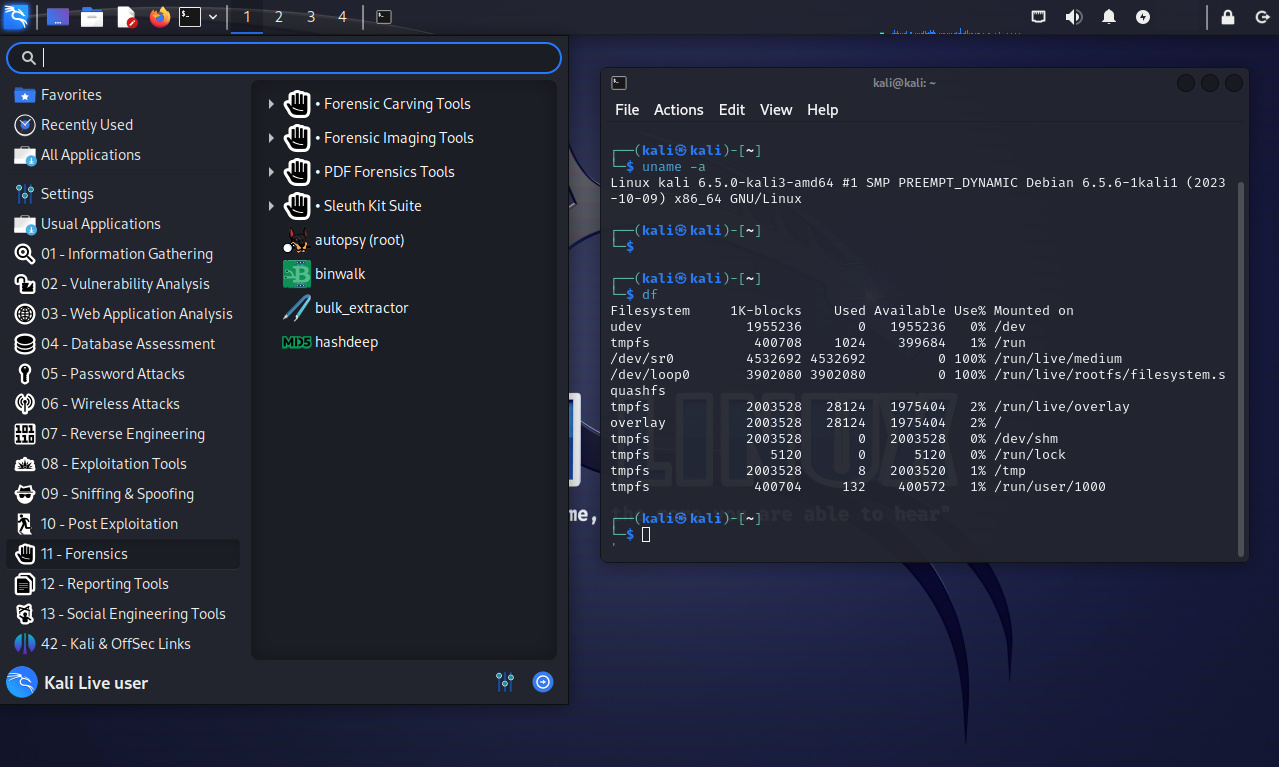

Herramientas para línea de comando en la capa de unidad de datos

Las herramientas en línea de comando de The Sleuth Kit están organizadas en capas. Las herramientas para la capa de unidades de datos comienzan con 'blk', la cual es la abreviatura de bloque. Se sugiere consultar la descripción general de la herramienta The Sleutk Kit para obtener más detalles sobre las capas de herramientas.

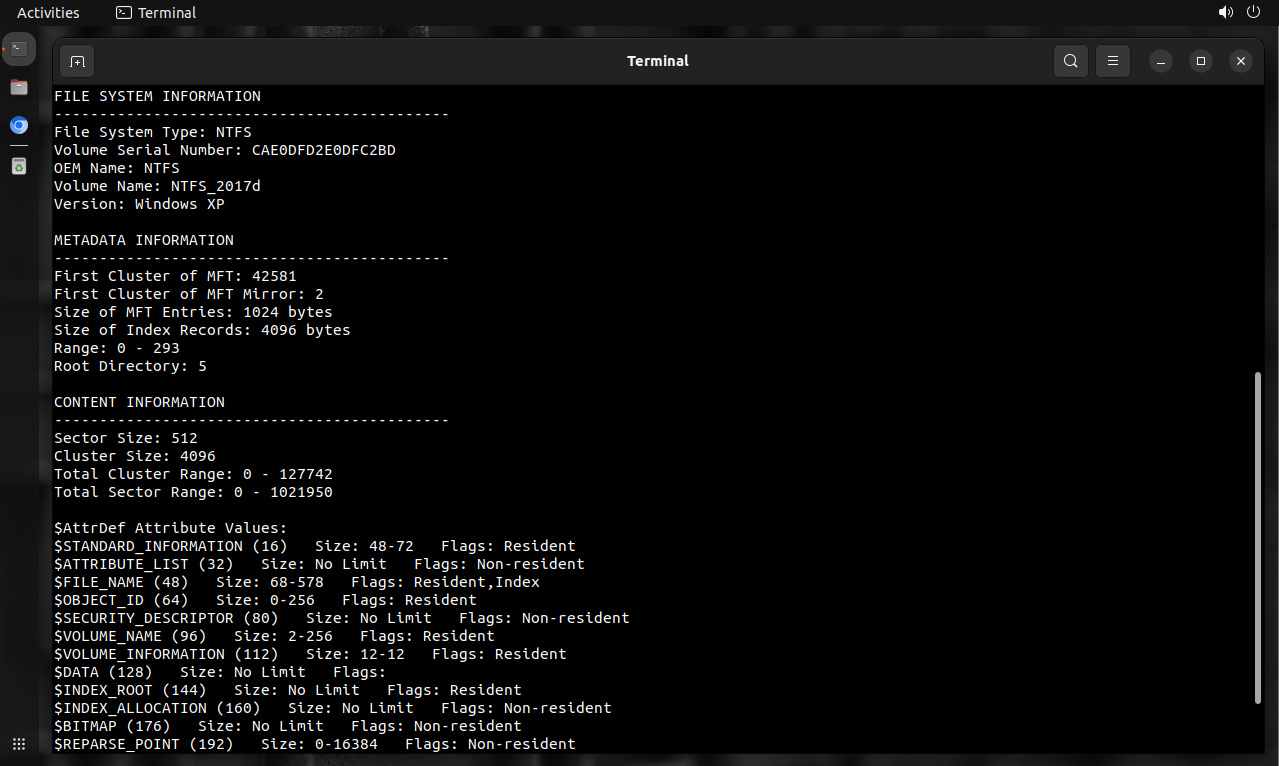

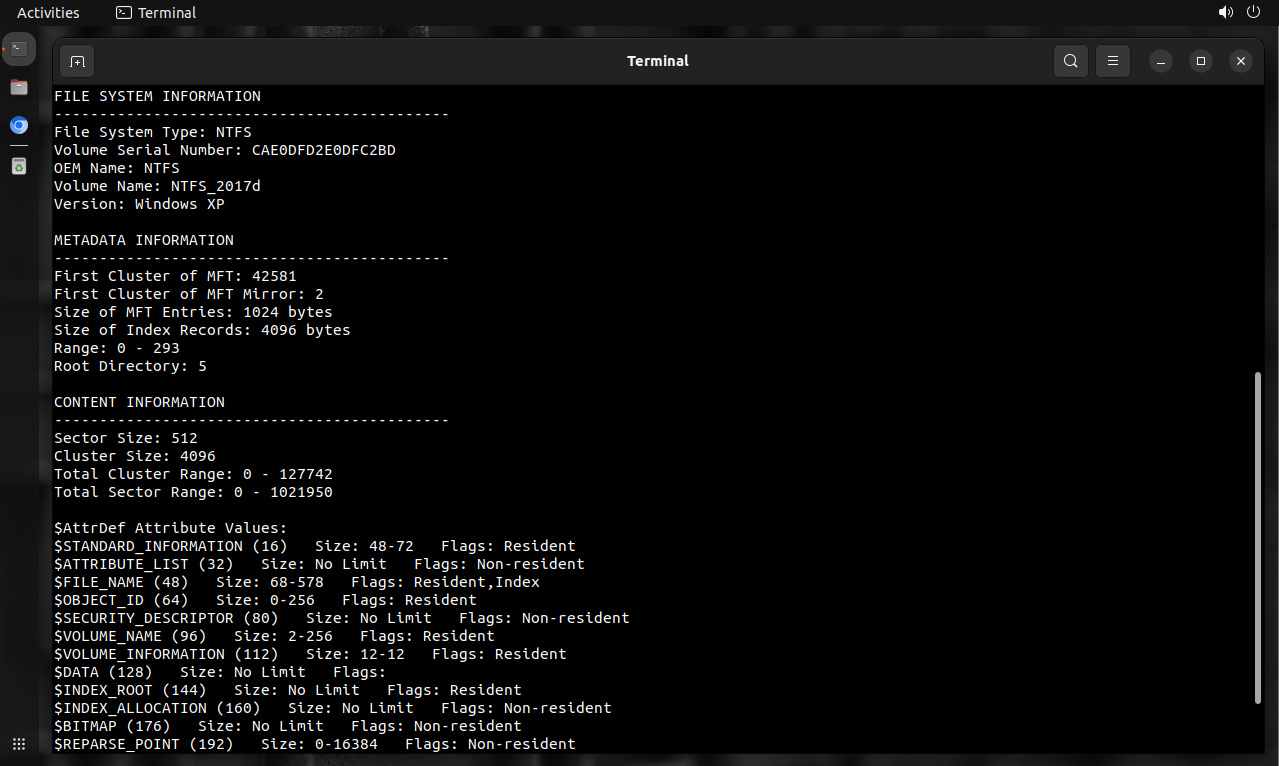

NTFS: clúster

Clúster es el término utilizado en los sistemas de archivos FAT y NTFS para referirse a una agrupación de sectores consecutivos. Los sectores son típicamente de 512 bytes cada uno, y es más eficiente para un sistema de archivos asignar y utilizar varios sectores al mismo tiempo. Cada sistema de archivos utiliza un término diferente para el grupo resultante. The Sleutk Kit utiliza el término unidad de datos para referirse a la agrupación.

Se sugiere consulte las notas de implementación para FAT, y obtener una descripción de la razón por la cual The Sleutk Kit utiliza direcciones de sector y no de clúster cuando trabaja con sistemas de archivos FAT.

YAFFS2: trozo (anotar YAFFS2 agrupa múltiples trozos en bloques, pero cada fragmento tiene una dirección)

Un trozo es la unidad de datos utilizada por YAFFS2. Consta de página y zona de repuesto. Típicamente se han visto tamaños de página de 2048 bytes, y un tamaño libre de 64 bytes.

Fuentes:

http://wiki.sleuthkit.org/index.php?title=Data_units

http://wiki.sleuthkit.org/index.php?title=Fragment

http://wiki.sleuthkit.org/index.php?title=Sector

http://wiki.sleuthkit.org/index.php?title=Block

http://wiki.sleuthkit.org/index.php?title=Cluster

http://wiki.sleuthkit.org/index.php?title=Chunk